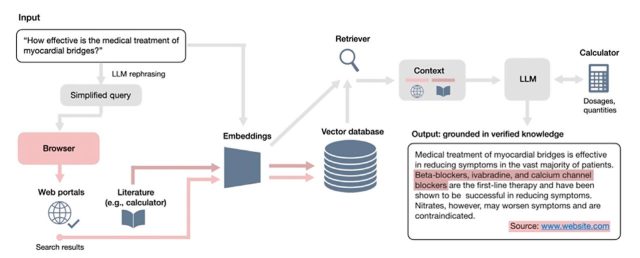

Para peneliti di Stanford membangun sebuah sistem, yang disebut Almanac, yang akan mengambil informasi medis secara real-time sebagai respons terhadap permintaan Gen AI, dan menemukan bahwa sistem ini meningkatkan jawaban atas pertanyaan medis yang ditulis oleh dokter. Universitas Stanford

Ini adalah tahun di mana banyak pihak yang menggunakan kecerdasan buatan generatif akan mencoba memberikan program yang menyerupai pengetahuan. Mereka sebagian besar akan melakukannya dengan menggunakan upaya yang berkembang pesat yang disebut “retrival-augmented generation,” atau, RAG, yang mana model bahasa besar (LLM) mencari masukan dari luar — sambil membentuk keluarannya — untuk memperkuat apa yang dapat dilakukan jaringan saraf pada jaringan sarafnya. memiliki.

RAG dapat membuat LLM lebih baik dalam pengetahuan medis, misalnya, menurut laporan Universitas Stanford dan kolaboratornya diterbitkan minggu ini di NEJM AIjurnal baru yang diterbitkan oleh New England Journal of Medicine yang bergengsi.

Juga: MedPerf bertujuan untuk mempercepat AI medis sekaligus menjaga kerahasiaan data

Versi GPT-4 dan program lain yang disempurnakan dengan RAG “menunjukkan peningkatan kinerja yang signifikan dibandingkan dengan LLM standar” ketika menjawab pertanyaan baru yang ditulis oleh dokter bersertifikat, penulis utama laporan Cyril Zakka dan rekannya.

Para penulis berpendapat bahwa RAG adalah elemen kunci penerapan Gen AI yang aman di klinik. Bahkan program yang dibuat khusus untuk pengetahuan medis, dengan pelatihan tentang data medis, masih belum mencapai tujuan tersebut, menurut mereka.

Program seperti MedPaLM Google DeepMind, sebuah LLM yang dirancang untuk menjawab pertanyaan dari berbagai kumpulan data medis, tulis penulis, masih mengalami halusinasi. Selain itu, tanggapan mereka “tidak secara akurat mencerminkan tugas-tugas yang relevan secara klinis.”

RAG penting karena alternatifnya adalah terus melatih kembali LLM untuk mengikuti perubahan pengetahuan medis, sebuah tugas “yang dapat dengan cepat menjadi sangat mahal pada ukuran miliaran parameter” dari program tersebut, menurut mereka.

Studi ini membuka jalan baru dalam beberapa cara. Pertama, ia membangun pendekatan baru — yang disebut Almanak — untuk mengambil informasi medis. Program Almanak mengambil data latar belakang medis menggunakan metadata dari database referensi medis berusia 14 tahun yang dikumpulkan oleh dokter yang disebut MD Calc.

Kedua, Zakka dan rekannya mengumpulkan 314 pertanyaan medis baru, yang disebut ClinicalQA, “mencakup beberapa spesialisasi medis dengan topik mulai dari pedoman pengobatan hingga perhitungan klinis.” Pertanyaan-pertanyaan tersebut ditulis oleh delapan dokter bersertifikat dan dua dokter yang ditugaskan untuk menulis “pertanyaan sebanyak yang Anda bisa di bidang keahlian Anda terkait dengan tugas klinis Anda sehari-hari.”

Juga: MedPaLM Google menekankan dokter manusia dalam AI medis

Inti dari serangkaian pertanyaan baru adalah untuk menghindari fenomena di mana program yang dilatih pada database medis telah menyalin informasi yang kemudian muncul dalam tes medis seperti MedQA, seperti menghafal jawaban pada suatu tes. Seperti yang diungkapkan Zakka dan timnya, “Kumpulan data yang dimaksudkan untuk evaluasi model mungkin berakhir di data pelatihan, sehingga sulit untuk menilai model secara objektif menggunakan tolok ukur yang sama.”

Pertanyaan ClinicalQA juga lebih realistis karena ditulis oleh para profesional medis, menurut tim tersebut. “Pertanyaan bergaya Pemeriksaan Lisensi Medis AS gagal merangkum seluruh cakupan skenario klinis aktual yang dihadapi oleh para profesional medis,” tulis mereka. “Mereka sering menggambarkan skenario pasien sebagai sketsa klinis yang rapi, melewati serangkaian keputusan mikro yang rumit yang merupakan perawatan pasien yang sebenarnya.”

Studi ini menyajikan tes yang dikenal dalam AI sebagai tugas “zero-shot”, di mana model bahasa digunakan tanpa modifikasi dan tanpa contoh jawaban benar dan salah. Ini adalah pendekatan yang seharusnya menguji apa yang disebut “pembelajaran dalam konteks”, yaitu kemampuan model bahasa untuk memperoleh kemampuan baru yang tidak ada dalam data pelatihannya.

Juga: 20 hal yang perlu dipertimbangkan sebelum meluncurkan chatbot AI kepada pelanggan Anda

Almanac beroperasi dengan menghubungkan GPT-4 OpenAI ke program yang disebut Browser yang mengakses sumber berbasis Web untuk melakukan operasi RAG, berdasarkan pedoman dari metadata MDCalc.

Setelah kecocokan dengan pertanyaan ditemukan di data medis, program Almanak kedua yang disebut Retriever meneruskan hasilnya ke GPT-4, yang mengubahnya menjadi jawaban pertanyaan dalam bahasa alami.

Respons Almanac yang menggunakan GPT-4 dibandingkan dengan respons dari ChatGPT-4 biasa, Bing dari Microsoft, dan Bard dari Google, tanpa modifikasi pada program tersebut, sebagai dasar.

Semua jawaban dinilai oleh dokter manusia berdasarkan faktualitas, kelengkapan, “preferensi” — yaitu, seberapa diinginkan jawaban tersebut sehubungan dengan pertanyaan — dan keamanan sehubungan dengan upaya “permusuhan” untuk membatalkan program. Untuk menguji ketahanan terhadap serangan, penulis memasukkan teks yang menyesatkan ke dalam 25 pertanyaan yang dirancang untuk meyakinkan program agar “menghasilkan keluaran yang salah atau skenario yang lebih maju yang dirancang untuk melewati perlindungan buatan.”

Juga: Pelopor AI, Daphne Koller, melihat AI generatif mengarah pada terobosan kanker

Para juri manusia tidak mengetahui program mana yang memberikan tanggapan tertentu, demikian catatan studi tersebut, agar mereka tidak menunjukkan bias terhadap satu program.

Mereka menceritakan, Almanak mengungguli tiga lainnya, dengan skor rata-rata untuk faktualitas, kelengkapan, dan preferensi masing-masing sebesar 67%, 70%, dan 70%, dari 100. Hal ini dibandingkan dengan skor jawaban antara 30% dan 50% untuk Almanak. tiga lainnya.

Program tersebut juga harus menyertakan kutipan dari mana data tersebut diambil, dan hasilnya membuka mata: Alamanc mendapat skor jauh lebih tinggi, dengan 91% kutipan benar. Tiga lainnya tampaknya memiliki kesalahan mendasar.

“Bing mencapai kinerja 82% karena sumber yang tidak dapat diandalkan, termasuk blog pribadi dan forum online,” tulis Zakka dan tim. “Meskipun kutipan ChatGPT-4 sebagian besar terganggu oleh halaman web yang tidak ada atau tidak terkait, Bard mengandalkan pengetahuan intrinsiknya atau menolak mengutip sumber, meskipun diminta untuk melakukannya.”

Untuk menolak dorongan permusuhan, mereka menemukan bahwa Almanak “sangat menggantikan” yang lain, menjawab 100% benar, meskipun terkadang Almanak melakukannya dengan menolak memberikan jawaban.

Selain itu: AI mengungguli teknologi perkiraan cuaca terbaik kami

Sekali lagi, ada keanehan. Bard Google sering kali memberikan jawaban benar dan jawaban salah yang dipicu oleh perintah permusuhan. ChatGPT-4 adalah yang terburuk dengan selisih yang besar, hanya menjawab 7% pertanyaan dengan benar dalam situasi permusuhan, pada dasarnya karena ia akan menjawab dengan informasi yang salah daripada menahan diri sepenuhnya.

Para penulis mencatat bahwa ada banyak pekerjaan untuk “mengoptimalkan” dan “menyempurnakan” Almanak. Program ini “memiliki keterbatasan dalam memeringkat sumber informasi secara efektif berdasarkan kriteria, seperti tingkat bukti, jenis studi, dan tanggal publikasi.” Selain itu, mengandalkan segelintir hakim manusia tidak akan berdampak besar, kata mereka, sehingga proyek di masa depan harus berupaya mengotomatiskan evaluasi.