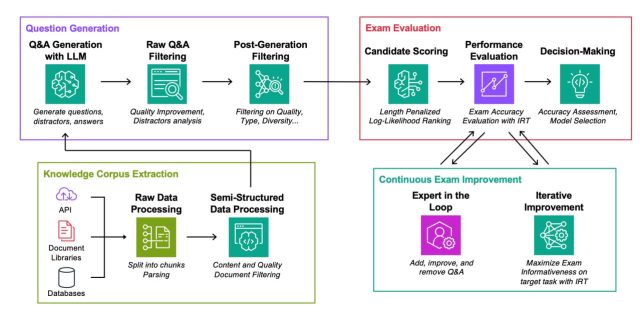

Garis besar proses pembandingan yang diusulkan Amazon untuk implementasi RAG pada AI generatif.

Amazon.com: Layanan AWS

Tahun ini seharusnya menjadi tahun dimana kecerdasan buatan generatif (GenAI) mulai berkembang di dunia usaha, menurut banyak pengamat. Salah satu cara hal ini dapat terjadi adalah melalui retrieval-augmented generation (RAG), sebuah metodologi yang menghubungkan model bahasa AI besar ke database yang berisi konten khusus domain seperti file perusahaan.

Namun, RAG adalah teknologi baru yang memiliki kekurangan.

Juga: Berikan ruang bagi RAG: Bagaimana keseimbangan kekuatan Gen AI berubah

Oleh karena itu, para peneliti di AWS Amazon mengusulkan dalam makalah baru untuk menetapkan serangkaian tolok ukur yang secara khusus akan menguji seberapa baik RAG dapat menjawab pertanyaan tentang konten khusus domain.

“Metode kami adalah strategi yang otomatis, hemat biaya, dapat ditafsirkan, dan kuat untuk memilih komponen optimal untuk sistem RAG,” tulis penulis utama Gauthier Guinet dan tim dalam karya tersebut, “Evaluasi Otomatis Model Bahasa yang Ditingkatkan dengan Pembuatan Ujian Khusus Tugas,” diposting di server pracetak arXiv.

Makalah ini dipresentasikan pada Konferensi Internasional ke-41 tentang Pembelajaran Mesinkonferensi AI yang berlangsung pada 21-27 Juli di Wina.

Masalah mendasarnya, jelas Guinet dan tim, adalah bahwa meskipun ada banyak tolok ukur untuk membandingkan kemampuan berbagai model bahasa besar (LLM) pada berbagai tugas, khususnya di bidang RAG, tidak ada pendekatan “kanonik” untuk pengukuran yang adalah “evaluasi tugas spesifik yang komprehensif” terhadap banyak kualitas yang penting, termasuk “kebenaran” dan “faktualitas”.

Para penulis percaya bahwa metode otomatis mereka menciptakan keseragaman tertentu: “Dengan secara otomatis menghasilkan ujian pilihan ganda yang disesuaikan dengan korpus dokumen yang terkait dengan setiap tugas, pendekatan kami memungkinkan penilaian yang terstandarisasi, dapat diskalakan, dan dapat ditafsirkan dari berbagai sistem RAG.”

Untuk memulai tugas itu, penulis membuat pasangan pertanyaan-jawaban dengan mengambil materi dari empat domain: dokumen pemecahan masalah AWS mengenai topik DevOps; abstrak artikel makalah ilmiah dari server pracetak arXiv; pertanyaan di StackExchange; dan pengajuan dari Komisi Sekuritas & Bursa AS, kepala regulator perusahaan yang terdaftar di bursa.

Juga: Menghubungkan AI generatif ke data medis meningkatkan kegunaan bagi dokter

Mereka kemudian merancang tes pilihan ganda untuk LLM guna mengevaluasi seberapa dekat setiap LLM dengan jawaban yang benar. Mereka menguji dua kelompok LLM sumber terbuka — Mistral, dari perusahaan Prancis dengan nama yang sama, dan Llama dari Meta Properties.

Mereka menguji model dalam tiga skenario. Yang pertama adalah skenario “buku tertutup”, di mana LLM tidak memiliki akses sama sekali ke data RAG, dan harus bergantung pada “parameter” — atau “bobot” saraf yang telah dilatih sebelumnya untuk menghasilkan jawabannya. Yang kedua adalah apa yang disebut bentuk RAG “Oracle”, di mana LLM diberikan akses ke dokumen persis yang digunakan untuk menghasilkan pertanyaan, kebenaran dasar, seperti yang diketahui.

Bentuk ketiga adalah “pengambilan klasik,” di mana model harus mencari di seluruh set data untuk mencari konteks pertanyaan, menggunakan berbagai algoritma. Beberapa rumus RAG populer digunakan, termasuk satu diperkenalkan pada tahun 2019 oleh para peneliti di Universitas Tel-Aviv dan Institut Allen untuk Kecerdasan Buatan, MultiQA; dan yang lebih tua tapi pendekatan yang sangat populer untuk pengambilan informasi yang disebut BM25.

Selain itu: Microsoft Azure mendapatkan ‘Model sebagai Layanan’, penawaran RAG yang ditingkatkan untuk AI generatif perusahaan

Mereka kemudian menjalankan ujian dan menghitung hasilnya, yang cukup kompleks untuk mengisi banyak bagan dan tabel tentang kekuatan dan kelemahan relatif LLM dan berbagai pendekatan RAG. Para penulis bahkan melakukan meta-analisis terhadap soal-soal ujian mereka –untuk mengukur kegunaannya — berdasarkan “pengetahuan” yang terkenal di bidang pendidikan.Taksonomi Bloom“.”

Yang lebih penting daripada titik data dari ujian adalah temuan umum yang dapat berlaku pada RAG — terlepas dari detail implementasinya.

Salah satu temuan umum adalah bahwa algoritma RAG yang lebih baik dapat meningkatkan LLM lebih dari, misalnya, membuat LLM lebih besar.

“Pilihan metode pengambilan yang tepat sering kali dapat menghasilkan peningkatan kinerja melebihi sekadar memilih LLM yang lebih besar,” tulis mereka.

Hal ini penting mengingat kekhawatiran atas meningkatnya intensitas sumber daya GenAI. Jika Anda dapat berbuat lebih banyak dengan lebih sedikit, ini adalah jalan yang berharga untuk dijelajahi. Hal ini juga menunjukkan bahwa kebijaksanaan konvensional dalam AI saat ini, bahwa penskalaan selalu merupakan yang terbaik, tidak sepenuhnya benar dalam menyelesaikan masalah nyata.

Juga: AI Generatif adalah vektor serangan baru yang membahayakan perusahaan, kata CTO CrowdStrike

Sama pentingnya, penulis menemukan bahwa jika algoritma RAG tidak bekerja dengan benar, hal ini dapat menurunkan kinerja LLM dibandingkan dengan versi vanilla biasa yang tidak memiliki RAG.

“Komponen pengambil yang tidak selaras dapat menyebabkan akurasi yang lebih buruk daripada tidak adanya pengambilan sama sekali,” begitulah yang dikatakan Guinet dan timnya.