CriticGPT adalah model AI berbasis jaringan saraf yang mengkritik kode yang dibuat oleh ChatGPT dan menunjukkan bug dalam kode tersebut.

OpenAI

Masalah halusinasi — model kecerdasan buatan (AI) yang menegaskan kepalsuan dengan kedok otoritas — telah menyebabkan sejumlah ilmuwan menyimpulkan bahwa AI generatif tidak dapat mendeteksi atau mengoreksi kesalahannya.

Dalam sebuah makalah pada bulan Oktober lalu, para peneliti di DeepMind Google berpendapat bahwa “LLM belum mampu mengoreksi sendiri penalarannya.”

Juga: Jika AI begitu menakjubkan, mengapa ChatGPT gagal saat mengerjakan tugas edit gambar sederhana ini?

Namun, pencipta ChatGPT OpenAI tidak setuju dengan pernyataan ini — dan minggu lalu perusahaan tersebut menawarkan versi GPT-4, yang disebut CriticGPT, yang diklaim dapat membantu menemukan dan memperbaiki kesalahan guna meningkatkan akurasi model secara keseluruhan.

Hasilnya menggembirakan bagi tim manusia yang membersihkan kode dengan bantuan AI. Namun, hasilnya juga menunjukkan bahwa tidak ada cara untuk menghindari halusinasi dari bot yang membantu.

Juga: AI generatif tidak dapat menemukan kesalahannya sendiri. Apakah kita memerlukan petunjuk yang lebih baik?

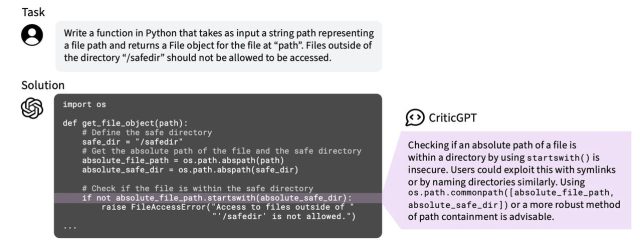

Latar belakang CriticGPT adalah penulisan kode pemrograman: para peneliti mengusulkan CriticGPT sebagai jaringan saraf kedua yang menyimpan kejadian ketika ChatGPT membuat kesalahan dalam kode yang dihasilkannya.

Mereka fokus pada penulisan kode karena, seperti yang mereka katakan, kode komputer itu “jelas” — memiliki jawaban yang benar dan salah yang jelas. Selain itu, OpenAI sebagai sebuah organisasi berharap untuk menggunakan AI generatif sebagai “asisten penelitian penyelarasan”, untuk mengotomatiskan beberapa penetapan batas bagi teknologi yang sedang berkembang. Penulisan kode sudah menjadi pengguna besar AI generatif, jadi ini merupakan target yang berharga untuk dikejar.

Dalam makalah yang diposting di server pra-cetak arXiv, “Kritikus LLM Membantu Menangkap Bug LLM,” penulis utama Nat McAleese dari OpenAI dan rekan-rekannya menggambarkan apa yang mereka sebut, “demonstrasi pertama dari metode pengawasan sederhana yang dapat diskalakan yang membantu manusia menemukan masalah secara lebih komprehensif dalam data RLHF dunia nyata.”

RLHF (reinforcement learning from human feedback) merujuk pada praktik yang sudah dikenal luas untuk menjadikan chatbot sebagai objek respons dari manusia agar output-nya lebih dapat diterima. Ini adalah salah satu cara OpenAI dan yang lainnya menetapkan pembatas untuk mencoba dan mencegah perilaku yang tidak diinginkan.

Dalam kasus ini, CriticGPT tunduk pada umpan balik dari programmer kontrak manusia yang meninjau kritik yang dihasilkan CriticGPT terhadap kode pemrograman. Manusia menilai kritik yang dihasilkan berdasarkan relevansi, spesifisitas, kelengkapan, dan banyak lagi. CriticGPT dilatih untuk menyempurnakan kritik berdasarkan umpan balik manusia untuk mendekati skor persetujuan yang lebih tinggi.

Juga: Apakah AI berbohong kepada kita? Para peneliti ini membangun semacam detektor kebohongan LLM untuk mencari tahu

Namun, McAleese dan tim mengambil langkah ekstra. Mereka memperbaiki beberapa bug yang disengaja dalam kode yang ditinjau CriticGPT dengan meminta beberapa kontraktor manusia secara sengaja memasukkan kesalahan. Para peneliti ingin para kontraktor menjelaskan bug mereka dan agar CriticGPT menyerap penjelasan tersebut dan belajar mengaitkan bug dengan penjelasan.

Harapannya adalah bahwa CriticGPT akan meningkat karena menghasilkan deskripsi bug yang mendekati apa yang telah ditulis oleh kontraktor manusia tentang bug yang sudah diketahui.

Hasil pelatihan, tulis McAleese dan tim, adalah bahwa ChatGPT menemukan lebih banyak bug daripada peninjau kode manusia. CriticGPT “sangat meningkatkan tingkat deteksi bug yang dimasukkan, dengan kedua kritikus LLM (ChatGPT dan CriticGPT yang diminta) mendeteksi lebih banyak bug daripada pencatat manusia,” tulis mereka.

Mereka mencatat bahkan kontraktor manusia lebih menyukai apa yang dihasilkan mesin dalam analisis kode dibandingkan dengan apa yang ditulis rekan manusia mereka.

“Kritik yang ditulis oleh CriticGPT jauh lebih disukai oleh kontraktor daripada kritik yang dibuat oleh ChatGPT dan kritik yang ditulis oleh manusia yang bersumber dari kelompok kontraktor kami menurut peringkat keseluruhan.”

Model AI membantu kontraktor manusia untuk memperkaya kritik bug mereka, semacam hasil AI yang melengkapi manusia yang seharusnya menyenangkan semua orang: “Tim Human+CriticGPT menulis kritik yang jauh lebih komprehensif daripada manusia saja dan CriticGPT meningkatkan kelengkapannya daripada ChatGPT pada bug yang dideteksi dan dimasukkan manusia.”

Seperti yang ditulis oleh penulis dalam postingan blog pendamping“Saran-saran CriticGPT tidak selalu benar, tetapi kami menemukan bahwa saran-saran tersebut dapat membantu pelatih untuk menemukan lebih banyak masalah dengan jawaban yang ditulis berdasarkan model daripada yang dapat mereka temukan tanpa bantuan AI.”

Juga: Bisakah AI membuat kode? Hanya dalam tahap awal

Namun ada kendalanya. Sama seperti ChatGPT dan berbagai model AI yang dapat “berhalusinasi” atas pernyataan yang salah, ternyata CriticGPT juga dapat mengklaim dapat mengidentifikasi bug yang sebenarnya tidak ada.

“Akan tetapi, kami menemukan bahwa tingkat kesalahan kecil dan halusinasi jauh lebih tinggi pada model daripada pada manusia, meskipun CriticGPT mampu mengurangi tingkat ini secara substansial melalui ChatGPT,” tulis mereka.

CriticGPT berhalusinasi mengenai bug dalam kode manusia.

OpenAI

Itulah dilemanya: semakin baik model AI dalam mendeteksi bug, semakin ia berhalusinasi tentang bug: “Sayangnya, tidak jelas apa keseimbangan yang tepat antara halusinasi dan deteksi bug untuk sistem RLHF keseluruhan yang menggunakan kritik untuk meningkatkan kinerja model.”

Dan tidak mudah untuk menemukan jalan tengah, mereka mencatat, karena, “Sebuah eksperimen ideal akan menjalankan putaran pengumpulan data RLHF yang ditingkatkan kritiknya secara terpisah untuk setiap titik presisi/ingatan; tetapi ini sangat mahal.”

Dalam pelanggaran tersebut, McAleese dan timnya mencapai kompromi. Force Sampling Beam Search mencoba mengangkat kritik CriticGPT yang paling berharga sekaligus meminimalkan jumlah kritik palsu.

Di antara potensi jebakan pendekatan OpenAI adalah bahwa pelatihan Critic GPT dibangun berdasarkan manusia yang memasukkan bug secara sengaja. Pendekatan itu, tulis McAleese dan tim, berbeda dari distribusi kesalahan LLM alami.

“Melatih model untuk menyisipkan masalah-masalah kecil dalam distribusi (dibandingkan membayar manusia untuk menyisipkan bug) mungkin dapat mengurangi kekhawatiran ini, tetapi kami menyerahkan arahan tersebut untuk pekerjaan di masa mendatang.”

Juga: Dari pelatih AI hingga ahli etika: AI mungkin membuat beberapa pekerjaan menjadi usang namun menghasilkan pekerjaan baru

Oleh karena itu, masalahnya akan selalu berkisar pada bagaimana melakukan bootstrap pada otomatisasi tanpa bantuan manusia.

Masalah lain — dan yang tidak disebutkan oleh penulis — adalah, seperti halnya semua hal yang berkaitan dengan OpenAI, baik model CriticGPT baru maupun data pelatihannya tidak tersedia untuk umum: semuanya tertutup, tidak ada kode sumber untuk pemeriksaan, tidak ada kumpulan data yang dapat diunduh orang lain. Penutupan itu berarti hampir tidak ada cara bagi pakar etika atau keamanan eksternal untuk memeriksa koreksi yang dibuat oleh model CriticGPT.

Tanpa pengawasan dari pihak mana pun di luar OpenAI, kata pepatah, siapa yang akan mengawasi para pengamat?